Définition

Voici les caractéristiques générales des systèmes de réécriture :- On part de

l'ensemble des mots sur un

alphabet (fini) X.

Cet ensemble sera ici désigné par X*, comme dans les cours précédents (à partir du cours n° 3).

L'opération de concaténation des mots va jouer un rôle essentiel.

- On se donne une famille R de couples de mots

(en termes mathématiques, R est une relation binaire sur X*) ;

Ces couples de mots qui sont appelés règles de réécriture.

On les note couramment avec une flèche : (a, b)∈ R s'écrira "a -> b", prononcé "a se réécrit en b".

- On étend la relation R en deux étapes, de la manière

suivante

- étant donnés deux mots quelconques u, v∈X*

et un couple (a, b)∈ R,

- on dit encore que le mot uav se réécrit en ubv [grâce à la règle (de réécriture) "a -> b"],

- et on note également "uav -> ubv".

- on considère la fermeture transitive de cette

relation :

en utilisant au besoin plusieurs couples (a,b), (a',b'), (a",b")∈ R

uav -> ubv = u'a'v' -> u'b'v' = u"a"v" -> u"b"v", etc.

et on note uav ->* u"b"v".[ bien noter l'étoile dans ->* ]

- étant donnés deux mots quelconques u, v∈X*

et un couple (a, b)∈ R,

- On se pose la question "étant donnés deux mots p, q

∈ X*, peut-on décider si p

->* q ?

Cette question est connue sous le nom de problème des mots pour le système considéré (en anglais word problem),

et on démontre qu'il n'y a pas de solution générale au problème des mots :

il n'existe pas d'algorithme qui prenne comme donnée la définition du système (ses règles de réécriture)

et qui fournisse une solution du problème des mots pour ce système.

Ce qu'on résume en disant que le problème des mots est indécidable.

Exemple

-

Définition

X = { '(', ')', '[' , ']', '{' , '}' , '<' , '>'} l'ensemble des "parenthèses généralisées" (voir la section de cours sur les arbres),

Nous notons 'ε' le mot vide.

Les règles de réécriture sont

- () -> ε

- [] -> ε

- {} -> ε

- <> -> ε

-

Montrons le processus

pour le mot "([]{<<>>}([(){<>}]))"

en procédant de gauche à droite pour choisir quelle règle appliquer :

([]{<<>>}([(){<>}]))-2>( {<<>>}([(){<>}]))

-4>({< >}([(){<>}]))-4>({ }([(){<>}]))-3>( ([(){<>}]))

-1>(([ {<>}]))-4>(([{ }]))-3>(([ ]))-2>(( ))-1>( )-1> ε

On aurait pu procéder de droite à gauche, en obtenant une suite de réécritures différente

mais conduisant au même résultat.

Toutes les réécritures possibles se résument sous la forme de l'arbre ci-dessous :

([]{<<>>}([(){<>}]))

2 4 1 4

( {< >}([ { }]))

4 3

( { }([ ]))3 2

( ( ))

1

( )

1

ε

-

Le problème des mots pour ce système est facile à résoudre

L'arbre ci-dessus se généralise à toutes les réécritures possibles à partir d'un mot quelconque,

aboutissant à un mot qui ne contient plus aucun digramme dela forme "ouvrante -fermante".

Étant donnés deux mots p, q ∈ X*, pour savoir si p ->* q, il suffit de tracer l'arbre des réécritures

à partir du mot p, et d'examiner si q apparaît à l'un de ses étages.

La clé du succès est ici que chaque réécriture aboutisse à un mot réécrit plus court que le mot d'origine.

C'est un système très particulier !

Les grammaires comme cas particulier de systèmes de réécriture

Définition : une grammaire est- un système de

réécriture dont l'alphabet est partagé en

deux parties non vides :

-

les symboles terminaux d'une part,

- les (symboles) non-terminaux d'autre part (aussi appelé symboles auxiliaires).

-

les symboles terminaux d'une part,

- on choisit un

symbole non-terminal appelé axiome,

traditionnellement désigné par S (comme start symbol)

(unique)

- on s'intéresse à

l'ensemble des mots w∈

X* tels que

- S ->* w (w peut être obtenu par réécriture à partir de l'axiome)

- et w ne

contient aucun symbole

non-terminal

- le problème des

mots (ou du

mot) pour une grammaire G est :

étant donné un mot (terminal) w, décider s'il appartient ou non au langage engendré par G.

L'originalité des grammaires parmi les systèmes de réécriture est cette nécessité de "chasser les non-terminaux"

dans le processus de génération des mots du langage.

Exemple : Grammaire G1

(les non-terminaux sont en majuscules, les terminaux en minuscules)

S -> aBScS -> abcBa -> aBBb -> bb

Essayons :

S -> aBSc -> aBaBScc

-> aBaBaBSccc

-> et en général -> (aB)nScn

par la règle 1.Pour chasser

S il faut employer la règle 2 :

-> (aB)nabccn

Pour chasser tous les

B, il faut les amener à

des positions où ils n'ont que des b

à leur droite,en les déplaçant grâce à la règle 3. On arrive ainsi à

aanBnbccn

, et par la règle 4 à aanbnbccn.On voit en outre que ce type de réécriture est le seul qui conduise à l'élimination complète des non-terminaux.

Le langage engendré par cette grammaire est donc {

anbncn

| n >0}.Grammaires et automates

-

Problématique

Toute la théorie des grammaires consiste à imposer diverses restrictions aux règles de réécriture

et à étudier l'impact de ces restrictions sur les solutions possibles au problème des mots.

Les solutions en question, qui sont des algorithmes, sont souvent décrites dans le format des automates

(cf. cours n° 4),

et on a coutume de mettre en rapport des classes de grammaires et des classe d'automates.

Nous verrons prochainement quelles restrictions sont nécessaires pour obtenir les automates finis.

Avant d'en arriver là, l'attention se porte sur la manière dont l'automate va gérer sa mémoire.

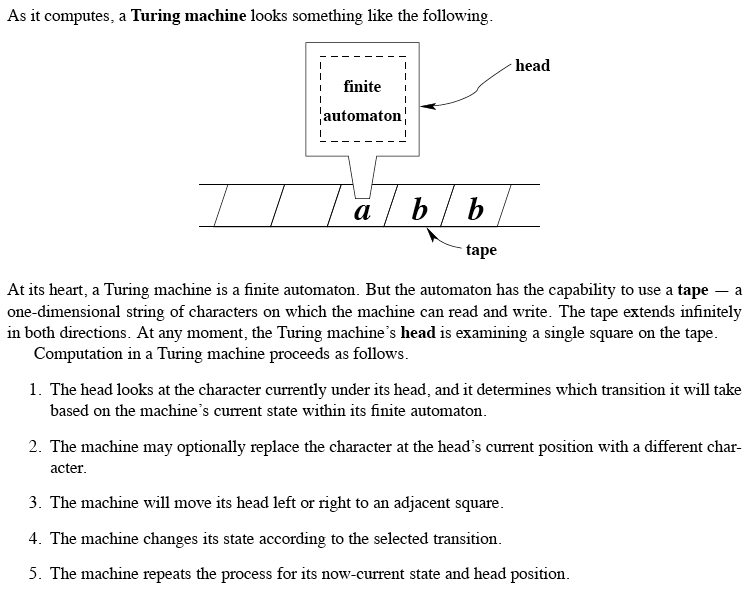

Cette mémoire est vue comme une bande infinie sur laquelle l'automate lit et écrit des informations

(des symboles comme ceux de l'alphabet), et le long de laquelle il peut déplacer sa tête de lecture-écriture,

à l'image des bandes magnétiques qui étaient un composant essentiel des ordinateurs d'autrefois.

-

Machines de Turing

Sous sa forme la plus générale, on appelle un tel automate une machine de Turing

(en hommage à Alan Turing, génial précurseur, qui inventa ce concept en 1936)

source :http://ozark.hendrix.edu/~burch/socs/written/text/v1.pdf

On a démontré que le modèle de la machine de Turing était une des formalisations de la notion de calculabilité :

tout ce qui est calculable peut être calculé par une machine de Turing. [Thèse de Church]

-

Résultat

La classe d'automates associée à la classe des grammaires sans restriction sur leurs règles

est celle des machines de Turing.

En d'autres termes, pour décider si un mot appartient au langage engendré par une grammaire,

il faut en général une machine de Turing.

Nous allons à présent envisager plusieurs restrictions sur la forme des règles de réécriture,

suivant la démarche dite de la hiérarchie de Chomsky.